Estudiante IMC y alumni UC presentan investigaciones en Austria

22 de Agosto, 2025

Diego Castelli y Pablo Rademacher expusieron en la conferencia SampTA (Sampling Theory and Applications) dos trabajos realizados en conjunto con el profesor Carlos Sing-Long y que derivan de sus estudios en el Magíster en Ingeniería Matemática y Computacional y el Magíster en Ciencias de la Ingeniería.

En 1995, la ciudad de Riga, en Letonia, fue escenario de un pequeño workshop sobre teoría de sampleo y las nuevas líneas de investigación que por ese entonces surgían en ese campo. A medida que el interés en el área fue creciendo, el evento comenzó a atraer un número cada vez mayor de matemáticos e ingenieros que estudiaban múltiples aplicaciones. Hoy la conferencia SampTA (Sampling Theory and Applications) se ha convertido en una de las más destacadas, gracias a su enfoque en ámbitos como el procesamiento de señales e imágenes, teoría de control, neurociencia computacional, teoría de la información y análisis complejo y real.

La versión 2025 de este evento se llevó a cabo recientemente en la Universidad de Viena (Austria). Entre los múltiples conferencistas y presentadores que participaron de esta edición estuvieron Pablo Rademacher (estudiante del Magíster en Ingeniería Matemática y Computacional), Diego Castelli (Magíster en Ciencias de la Ingeniería UC) y Carlos Sing-Long, académico del Instituto de Ingeniería Matemática y Computacional (IMC UC) e investigador del Centro Nacional de Inteligencia Artificial (CENIA).

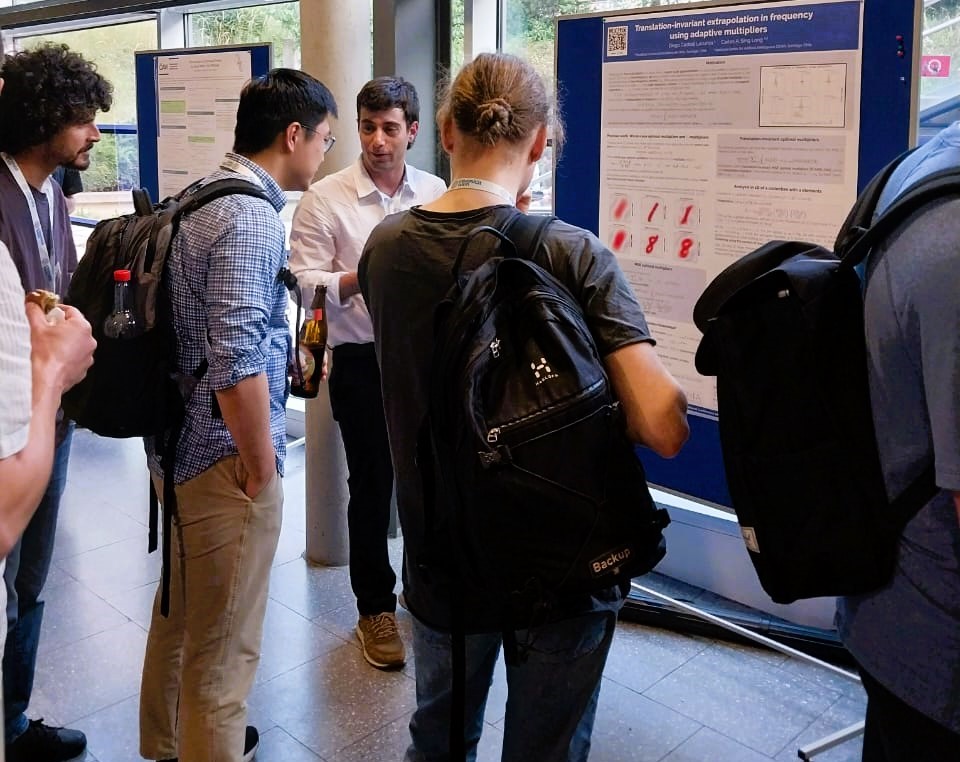

Diego Castelli, Carlos Sing-Long y Pablo Rademacher.

Diego Castelli presentó el poster Translation-invariant extrapolation in frequency using adaptive multipliers, trabajo realizado junto al profesor Sing-Long, quien fue su profesor guía durante el Magíster. El alumni UC, quien pronto iniciará su doctorado en el Real Instituto de Tecnología de Estocolmo (Suecia), explica la teoría de sampleo de la siguiente manera: “Al medir señales eléctricas, como sonido o luz, existen teoremas que demuestran que al realizar análisis cada cierto tiempo es posible recuperar dichas emisiones en la medida que tengan ciertas propiedades. La conferencia, precisamente, se orientó a la recuperación de señales a partir de sus mediciones”.

A nivel general, una aplicación está en las imágenes médicas: “En el caso, por ejemplo, de las resonancias magnéticas, se hacen vibrar partículas de agua a partir de imanes y eso genera señales eléctricas que uno tiene que medir en un sampleo, para después recuperarlas a partir de un proceso matemático que implica el uso de algunas ecuaciones”, indica Diego.

El alumni UC agrega que este año, la temática de la conferencia SampTA se dividió en dos grandes líneas: teoría de sampleo tradicional y sampleo de datos para inteligencia artificial. “En este último contexto, también puede haber sampleo, porque lo que se hace cuando hay un fenómeno dado que se quiere entender es sacar muestras o datos para después entrenarlos en una red neuronal. Esas son teorías de sampleo para que esa red aprenda”.

Sobre el trabajo que difundió en Viena, Diego explica que la investigación aborda la “capacidad de ampliar el rango de sampleo de un set de entrenamiento de imágenes, utilizando multiplicadores de Fourier, lo que básicamente equivale a multiplicar punto a punto las imágenes”. Eso implica tener más información de toda la imagen, por lo que a través de una serie de métodos matemáticos se logra tener una representación más precisa.

Diego indica que no se trata sólo de tener una imagen más nítida, sino que con más información. “Por ejemplo, si uno amplía un rango muy pequeño de la imagen de un número ‘8’ ni siquiera se van a ver los anillos que lo forman, sino que simplemente una mancha. Pero si uno le añade un rango un poco más grande, ya se ve la forma. Es decir, se recuperan elementos más fundamentales de la estructura que se está analizando”, señala.

Diego Castelli durante la sesión de posters.

Este trabajo deriva de la tesis que el alumni UC realizó para obtener su Magíster. “En este trabajo estudiamos qué pasaba si cambiábamos el enfoque de la imagen, si el ‘8’ estaba al medio de la imagen o más corrido. También cómo afectaba la manera en que la analizábamos y, si había algún problema, cómo corregirlo. Verificamos efectivamente que se generaba un problema y que la manera de corregirlo no era tan obvia como simplemente centrar todo y tratar de reconstruir. Había métodos mucho más elaborados y, de hecho, nos dimos cuenta de que centrar todo incluso podía ser perjudicial en algunos casos”, cuenta Diego.

Levantar y desenmascarar

Pablo Rademacher, estudiante del Magíster en Ingeniería Matemática y Computacional, también tiene como profesor guía a Carlos Sing-Long y en Viena dictó la charla titulada Lift and Unmask: Sparse Models by Lifting the Atomic Norm. Según cuenta el alumno, el trabajo nació de la investigación que realiza el profesor sobre la recuperación de señales: “Una señal puede representar una imagen o un audio que uno quiere conocer, pero en algunos casos uno no tiene acceso directo a la señal, sino que indirecto”.

A partir de dichas mediciones, lo que se intenta es recuperar la señal original. “Por lo general uno no toma suficientes mediciones como para caracterizar tu señal de manera única. Así que hay que asumir ciertas estructuras de la señal que uno le gustaría recuperar, para tener más probabilidad de lograrlo”, explica Pablo, quien pronto iniciará su doctorado en la Technische Universität Darmstadt (Alemania). El estudiante agrega que en la señal existen ciertos bloques llamados “átomos”, los cuales son conjuntos de elementos que representan una señal de manera eficiente. “Si tienes 100.000 ‘átomos’, puedes elegir sólo cinco y si los combinas de manera inteligente puedes recuperar una señal. La pregunta es cuáles son los ‘átomos’ que quieres recuperar y cuánto de cada uno ocupas”, agrega.

Para esa tarea, existe una herramienta llamada “norma atómica”. Un problema de este modelo, explica Pablo Rademacher, es que asume ciertas condiciones de los “átomos”: “En particular establece que ningún átomo es combinación de los otros. Por así decirlo, asume que todos los átomos son independientes entre sí. Si eso no pasa, entonces el método nunca va a elegir ese ‘átomo’ para recuperar una señal”.

Los asistentes a la conferencia en Viena (Crédito: SampTA)

Esto puede generar un problema: “Puede ser que tu señal la representes eficientemente usando estos ‘átomos’ ocultos, pero cuando no los consideres ya pierdes esa eficiencia”. Por ese motivo, indica el estudiante, lo que se necesita es desarrollar un método que pueda ocupar los “átomos” ocultos. “Eso es lo que hacemos y por eso el trabajo se llama ‘Lift and Unmask”. Lo que hacemos es levantar los ‘átomos’ y añadirles una dimensión extra a cada uno. Con eso los desenmascaramos para poder usarlos en la recuperación de señales”, agrega.

Una aplicación de esta técnica también podría darse en el área médica. “Nosotros la usamos en el problema de separación de agua y grasa que se da en las resonancias magnéticas. En ese ejemplo, quedan algunos ‘átomos’ ocultos por otros y que normalmente no podrías recuperar. Hicimos un par de experimentos donde mostramos que si la señal está compuesta por estos ‘átomos’ ocultos, nuestro método logra recuperarla en varios casos, mientras que la técnica original no lo consigue”, concluye.